”Spark Core 随笔“ 的搜索结果

SparkCore学习

标签: spark

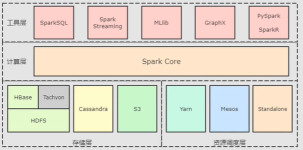

Spark 概念 Spark是一种基于内存的快速、通用、可扩展的大数据分析计算引擎 Spark 就是在传统的 MapReduce 计算框架的基础上,利用其计算过程的优化,从而大大加快了数据分析、挖掘的运行和读写速度,并将计算单元...

幼儿园安全教育随笔

Spark学习随笔(一)sbt源的配置

spark学习随笔(一)

标签: spark

学好了,就可以学习spark啦。 练习:构造一个1-5的List,把他们打印出来。 //构造一个List List<Integer> input = Arrays.asList(1, 2, 3, 4, 5); 打印 写法1 for ...

1、spark是一个apache开源项目 2、spark可以提升程序运行速度,spark在100TB数据比赛中战胜hadoop,并且只使用了十分之一的机器。 3、spark提供了java,scala和python语言api支持 4、spark可以与hadoop生态系统和...

docker 学习随笔

标签: docker 随笔

仅仅是个人通过自学对docker应用一些认知,随笔记录一下,敬请指教

当使用spark-submit提交一个作业之后,这个作业就会启动一个对应的driver进程。 根据你使用的部署模式(deploy-mode)不同,driver进程可能在本地启动,也可能在集群中某个工作节点上启动。 ...

Spark Streaming是核心Spark API的扩展,可实现实时数据流的可扩展,高吞吐量,容错流处理。数据可以从许多来源(如Kafka,Flume,Kinesis或TCP套接字)中获取,并且可以使用以高级函数表示的复杂算法进行处理map,...

琉璃块博客园首页新随笔联系订阅管理随笔 - 36 文章 - 0 评论 - 2Spark 以及 spark streaming 核心原理及实践收录待用,修改转载已取得腾讯云授权作者 | 蒋专蒋专,现CDG事业群社交与效果广告部微信广告中心业务...

# 基本配置 ```shell#目录结构: bin:二进制的客户端命令 etc:存放配置文件 etc/conf lib:存放jar包的目录 sbin:存放管理类的脚本启动服务 share:hadoop所有的jar包 #查看主机名 hostname#临时修改主机名 ...

Maven Archetype 类似Spring project initializer ,根据配置向导可以生成maven的projectsketch,这个模版中定义了pom文件和项目结构,java 代码的demo, 和编译运行所需要的基本的依赖等。 ...

1、原生javaWeb:不再用1)、导入...导包jackson-annotations-2.1.5.jarjackson-core-2.1.5.jarjackson-databind-2.1.5.jar3.无论是请求体还是响应体都是站在服务器端来说的,只不过@响应体写在上方,例如:@Respon...

由于最近在工作中刚接触到scala和Spark,并且作为python中毒者,爬行过程很是艰难,所以这一系列分为几个部分记录下学习《Spark快速大数据分析》的知识点以及自己在工程中遇到的小问题,以下阶段也是我循序了解Spark...

Flink随笔(1)

标签: flink

相比 Spark Stream、Kafka Stream、Storm 等,为什么阿里会选择 Flink 作为新一代流式计算引擎?前期经过了哪些调研和对比? 大沙:我们是 2015 年开始调研新一代流计算引擎的。我们当时的目标就是要设计一款低延迟...

还是写一篇随笔,免得以后自己忘记了。同事也给我一样苦逼的人参考。先说明一下,这里说的Hive on Spark是Hive跑在Spark上,用的是Spark执行引擎,而不是MapReduce,和Hive on Tez的道理一样。先看官网的资源Hive on...

1 foreachRDD ...代码:见上个随笔例子 2 transform transformation类算子 可以通过transform算子,对Dstream做RDD到RDD的任意操作。 代码: /** * 过滤黑名单 * transform操作 * DS...

还是写一篇随笔,免得以后自己忘记了。同事也给我一样苦逼的人参考。 先说明一下,这里说的Hive on Spark是Hive跑在Spark上,用的是Spark执行引擎,而不是MapReduce,和Hive on Tez的道理一样。 先看官网的...

posts - 179, comments - 29, trackbacks - 0, articles - 0 我的标签AI(47)R(24)architecture(14)other(13)HBase(11)EV(11)Elasticsearch(8)Hive(7)HDP(6)DW(6)更多随笔分类AI(45)algorithm(6)architecture(13)Doc...

spark shuffle:分区原理及相关的疑问 一、分区原理 1.为什么要分区?(这个借用别人的一段话来阐述。) 为了减少网络传输,需要增加cpu计算负载。数据分区,在分布式集群里,网络通信的代价很大,减少网络传输...

--本篇随笔由同事葛同学提供。 windows下spark开发环境配置 特注:windows下开发spark不需要在本地安装hadoop,但是需要winutils.exe、hadoop.dll等文件,前提是你已经安装了eclipse、maven、jdk等软件 spark支持...

还是写一篇随笔,免得以后自己忘记了。同事也给我一样苦逼的人参考。先说明一下,这里说的Hive on Spark是Hive跑在Spark上,用的是Spark执行引擎,而不是MapReduce,和Hive on Tez的道理一样。先看官网的资源Hive...

还是写一篇随笔,免得以后自己忘记了。同事也给我一样苦逼的人参考。 先说明一下,这里说的Hive on Spark是Hive跑在Spark上,用的是Spark执行引擎,而不是MapReduce,和Hive on Tez的道理一样。 先看官网的资源Hive ...

工作随笔-20171024 2017-10-25 10:10 by 轩脉刃, ... 阅读, ... 评论, 收藏, 编辑 appName(s"Crossroadfree") 这个是个什么语法? 这个是字符串插值用法,从scala2.10.0版本开始,在s""的里面可以使用$val来...

SparkSQL中的DataFrame本质上还是一个RDD但是DataFrame本质上又是一个DataSet,SparkSQL的中心是一个SparkCore,SparkCorez中RDD是核心。不说了直接上 第一种写法使用spark1.x版本 packag...

资源调度框架——YARN YARN的产生背景 MapReduce1.x存在的问题:单点故障(JT)&节点(JT)压力大不易拓展&...由此催生了YARN,是的不同计算框架可以共享同一个HDFS集群上的数据,享受整体...

如MapReduce,Spark(实时性比MapReduce好,可以做迭代计算,MapReduce不能) 流计算:针对流数据(日志流、用户点击流)的实时计算,需要实时处理。只能用流计算框架做。 流计算代表产品:S4+Storm+Flume 图...

推荐文章

- Python Django 版本对应表以及Mysql对应版本_django版本和mysql对应关系-程序员宅基地

- Maven的pom.xml文件结构之基本配置packaging和多模块聚合结构_pom <packaging>-程序员宅基地

- Composer 原理(二) -- 小丑_composer repositories-程序员宅基地

- W5500+F4官网TCPClient代码出现IP读取有问题,乱码问题_w5500 ping 网络助手 乱码 send(sock_tcps,tcp_server_buff,-程序员宅基地

- Python 攻克移动开发失败!_beeware-程序员宅基地

- Swift4.0_Timer 的基本使用_swift timer 暂停-程序员宅基地

- 元素三大等待-程序员宅基地

- Java软件工程师职位分析_java岗位分析-程序员宅基地

- Java:Unreachable code的解决方法_java unreachable code-程序员宅基地

- 标签data-*自定义属性值和根据data属性值查找对应标签_如何根据data-*属性获取对应的标签对象-程序员宅基地